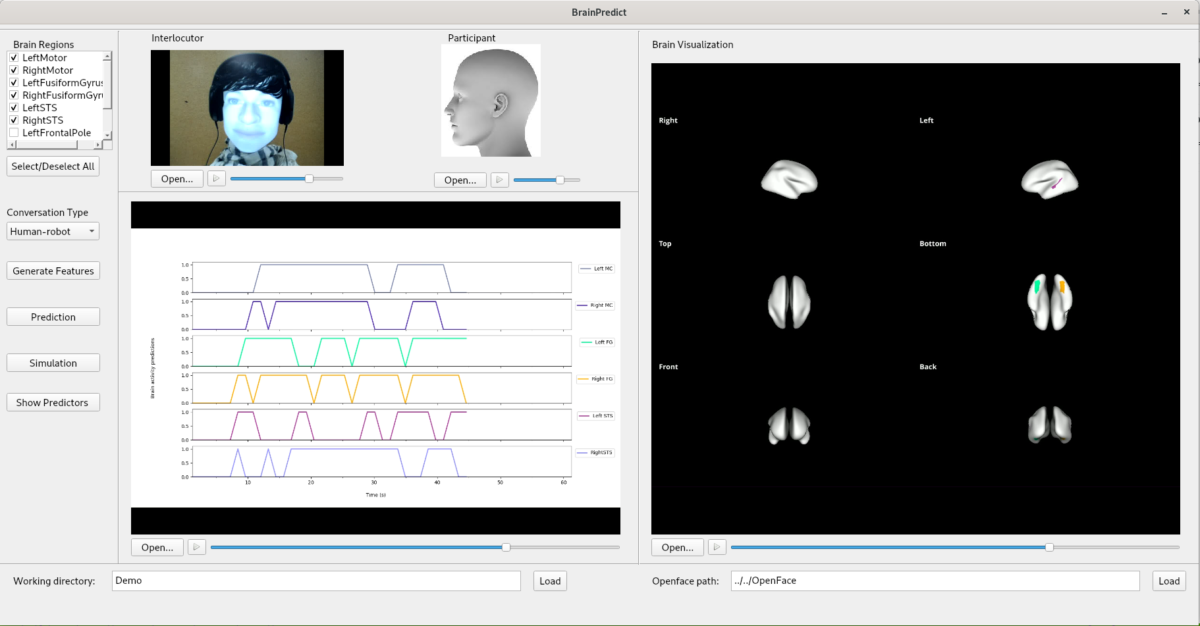

Youssef Hmamouche (post-doc LPL) et Laurent Prévot (professeur AMU et directeur du LPL) – en collaboration avec Magalie Ochs (LIS) et Thierry Chaminade (INS) – viennent de publier un article à propos de l’outil BrainPredict qui a pour vocation de prédire et de visualiser l’activité cérébrale pendant des conversations homme-homme ou homme-robot. Les premières études se sont déroulées avec 24 participants adultes en conversation naturelle d’environ 30 minutes. Les premiers résultats prometteurs ouvrent la voie pour de futures études en intégrant d’autres paramètres sociolinguistiques ou encore des aspects liés à certaines pathologies du langage.

Référence :

Youssef Hmamouche, Laurent Prevot, Magalie Ochs, Chaminade Thierry. BrainPredict: a Tool for Predicting and Visualising Local Brain Activity. Proceedings of The 12th Language Resources and Evaluation Conference, Nov 2020, Marseille, France. pp.703–709. ⟨hal-02612819⟩

Résumé :

Cet article présente une description de l’outil BrainPredict. Cet outil permet la prédiction dynamique et la visualisation de l’activité cérébrale locale d’un individu au cours d’une conversation. Le module de prédiction de cet outil est basé sur des classificateurs entraînés sur un corpus de conversations homme-homme et homme-robot, y compris des enregistrements IRMf. Ce module prend en entrée des variables comportementales calculées à partir de données de conversation brutes, principalement la parole du participant et de l’interlocuteur, et la saisie visuelle de l’interlocuteur et les mouvements oculaires du participant. Le module de visualisation permet de monter la dynamique des zones actives cérébrales synchronisées avec les données brutes comportementales. De plus, il montre les variables comportementales pertinentes pour prédire l’activité dans des zones cérébrales.

Lien vers le document : https://hal.archives-ouvertes.fr/hal-02612819/document

Lien vers HAL : https://hal.archives-ouvertes.fr/hal-02612819

***********

Cette publication a été réalisée à l’occasion de la prestigieuse conférence LREC prévue initialement à Marseille en 2020 – annulée en raison de la pandémie Covid-19 – et qui compte de nombreuses « contributions LPL » acceptées et publiées en ligne depuis le mois de mai telles que :

- Multimodal Corpus of Bidirectional Conversation of Human-human and Human-robot Interaction during fMRI Scanning ( Rauchbauer, Y. Hmamouche, B. Bigi, L. Prevot, M. Ochs, et al..),

- How to Compare Automatically Two Phonological Strings: Application to Intelligibility Measurement in the Case of Atypical Speech ( Ghio, M. Lalain, L. Giusti, C. Fredouille, V. Woisard),

- Identifying Abstract and Concrete Words in French to Better Address Reading Difficulties ( Goriachun, N. Gala),

- Have a Cake and Eat it Too: Assessing Discrimination Performance of an Intelligibility Index Obtained from a Reduced Sample Size ( Marczyk, A. Ghio, M. Lalain, M. Rebourg, C. Fredouille, et al.),

- PACO : A corpus to analyze the impact of common ground in spontaneous face-to-face interaction ( Amoyal, B. Priego-Valverde, S. Rauzy).

Crédit image : Y. Hmamouche